「AIに自社のことを聞いたら、全く違うサービス内容を回答された」 「公式サイトには書いていない情報が、事実のように語られていた」

生成AIの活用が進む中で、こうした現象に戸惑う企業が増えています。 AIが事実に基づかない情報を生成してしまう現象、「ハルシネーション(幻覚)」です。

実は先日、私たちMedifundもこの現象を目の当たりにしました。 新サービスをリリースした際、ChatGPTがそれを「地図コンサルティング」だと誤認したのです。

本記事では、実際の誤認事例を公開しながら、AIが情報を読み違えるメカニズムと、それを防ぐための具体的対策について解説します。

※本記事は実験レポート2件の解説編です。 下記でも概要を説明しますが、詳細を知りたい方は、ChatGPTが勘違いしていた様子を記録した[前回の記事]からご覧ください。

目次

1. 【実録】ChatGPTが自社サービスを「誤認」した瞬間

論より証拠。実際に私たちが経験した事例をご覧ください。

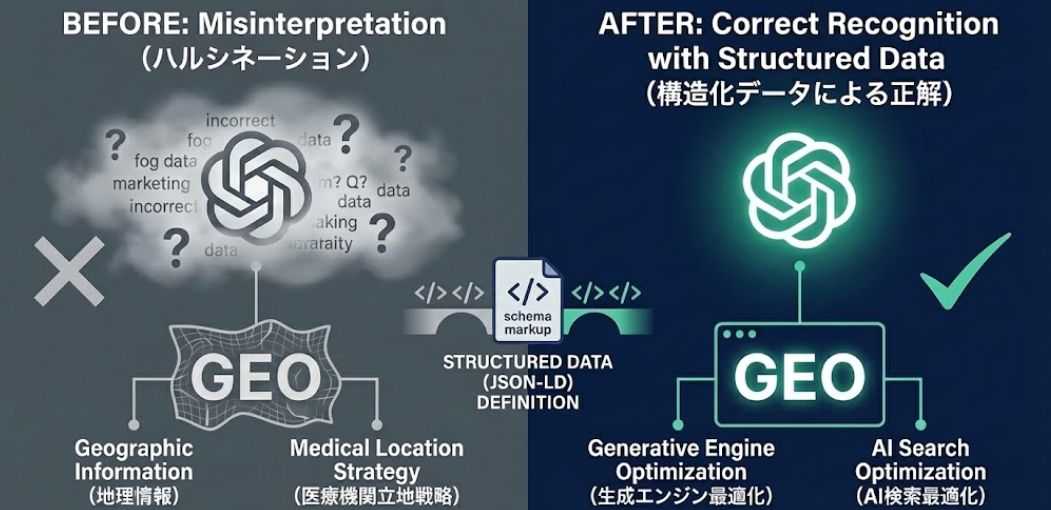

私たちは先日、「GEO(生成エンジン最適化)コンサルティング」という新サービスをリリースしました。 しかし、その直後にChatGPTにサービス内容を尋ねたところ、以下のような回答が返ってきました。

ChatGPTの回答(対策前): 「MedifundのGEOコンサルティングとは、地理情報(Geographic Information)を活用し、医療機関の立地戦略や海外展開を支援するサービスです。」

……いいえ、違います。 私たちはWebマーケティング会社であり、地図に関する事業は行っていません。 しかし、ChatGPTは文脈から推測し、自信満々に異なるサービス内容を提示しました。

これがハルシネーションの特徴です。情報の空白を埋めるために、もっともらしい推測を行ってしまうのです。

2. なぜAIは誤認するのか?(確率論の罠)

なぜ、公式サイトに「生成エンジン最適化」と書いてあるのに、AIは「地理情報」と解釈したのでしょうか? その原因は、AI(大規模言語モデル)の仕組みそのものにあります。

AIは「意味」ではなく「確率」で予測している

ChatGPTなどのLLMは、次にくる単語を「確率」で予測して文章を生成しています。

Web上の膨大なデータ全体で見ると、「GEO」という単語は「Geographic(地理)」という意味で使われているケースが圧倒的に多数です。「Generative Engine Optimization」という意味で使われているのは、まだ一部の最新情報に限られます。

そのため、AIの中で以下のような推論が行われたと考えられます。

- ユーザー:「MedifundのGEOについて教えて」

- AI:「GEOといえば…(確率的に高い)地理のことだな」

- AI:「Medifundは医療系(Medi)だから…(文脈的に)病院の立地戦略だろう」

- 結論:「医療機関向けの地理情報コンサルです」(誤った推論の完成)

テキスト情報だけで情報を伝えようとすると、この「AIの学習データの偏り(確率の壁)」を超えることが難しい場合があります。

3. 誤認を防ぐ最も効果的な手段「構造化データ」

では、どうすれば正しい情報を伝えられるのでしょうか? AIに「推測」させるのではなく、「事実(Fact)」として認識させる必要があります。

そのための切り札となるのが、「構造化データ(Schema Markup)」です。

AIに「定義書」を渡す

私たちは誤認発覚の翌日、WebサイトのHTMLコード内に以下の構造化データ(JSON-LD)を実装しました。

"serviceType": "AI Search Optimization"

// 訳:「このサービスの種類は『AI検索最適化』です」

これは人間には見えませんが、AIにとっては「情報の定義書」として機能します。 これを読み取ることで、AIは確率による推測よりも、明示された定義を優先するようになります。

対策後のChatGPTの反応

構造化データ投入から24時間後、再びChatGPTに聞きました。

ChatGPTの回答(対策後): 「MedifundのGEOコンサルティングは、**生成AI(ChatGPTやGoogle SGE)**において自社情報が引用されるよう最適化するサービスです。」

見事に認識が修正されました。 これが、私たちが提唱する「リバースGEO(AIの推論から逆算する技術)」の効果です。

4. 他にもある!企業がやるべきハルシネーション対策

構造化データ以外にも、AIの誤認を防ぐために有効な手段があります。

① Web上の「NAP情報」の統一

会社名(Name)、住所(Address)、電話番号(Phone)の表記を、Webサイト、SNS、求人サイトなどすべての媒体で一字一句統一します。 表記ゆれ(例:㈱Medifund と 株式会社メディファンド)が多いと、AIは「別の会社」と認識してしまい、情報の統合に失敗して誤った回答をしやすくなります。

② Googleビジネスプロフィールの整備(MEO)

Googleマップの情報は、GoogleのAI(Gemini/SGE)にとって非常に信頼度の高いソースとなります。 ここに正しい事業内容や最新情報を登録しておくことで、AIが公式サイト以外からも「正解」を参照できるようになります。

5. なぜ対策を「プロ」に任せるべきなのか?

「構造化データを入れるだけなら、自社でもできるのでは?」と思われるかもしれません。 しかし、GEO対策には高度な専門知識が必要であり、誤った設定は逆効果になるリスクがあります。

① 技術的な難易度とリスク

構造化データ(JSON-LD)はプログラミングコードの一種です。カンマ一つ間違えるだけで構文エラーとなり、検索エンジンからペナルティ(評価ダウン)を受ける可能性があります。また、誤った定義(例:ArticleタグとProductタグの混同など)をすると、かえってAIを混乱させてしまいます。

② AIアルゴリズムの激しい変化

GoogleやOpenAIのアルゴリズムは頻繁にアップデートされます。先月通用した記述が、今月は推奨されない記述になっていることも日常茶飯事です。 最新の仕様に合わせて常にメンテナンスし続けるには、専任の監視体制が必要です。

③ 「ハイブリッド」な視点が必要

AI対策(GEO)だけを行っても、検索順位(SEO)が下がってしまっては本末転倒です。 Webサイト全体の評価を高めながらAIにも最適化する「ハイブリッドGEO」の視点は、Webマーケティング全体を俯瞰できるプロフェッショナルならではの強みです。

■ まとめ:AIに「正しく」認識されるために

AI検索が普及するこれからの時代、企業情報は人間だけでなく、AIにも正しく伝わるように設計する必要があります。

特に、以下のようなケースでは誤認のリスクが高まる可能性があります。

- 社名やサービス名が、一般的な単語や略語と同じである。

- 業界内で似た名前の他社が存在する。

- Web上の情報量が少なく、AIが推測で補完しようとする。

「自社の情報は正しくAIに伝わっているだろうか?」

不安な方は、ぜひMedifundの「無料AI検索評判診断」をご活用ください。 現状のAIによる認識状況をチェックし、正しい情報を学習させるための最適なアプローチをご提案します。

(運営会社:セライオン株式会社)

無料ダウンロード|SEOキーワード選定バイブル

ブログ更新は本当に効果が出るのか心配ではありませんか?

毎月2~3記事の更新で問い合わせをもらうSEOキーワード選定マニュアル

・ブログからの売上が3ヶ月で3倍以上に

・更新開始から3ヶ月で約10,000PVを達成

・作業効率5倍以上UP

・社内のブログ更新が途絶えない

・ブログ⇛メルマガ登録の成約率が30倍に